Introduction

Code sur Github: Enrichissement des données Elasticsearch

Si vous n'avez pas encore configuré Elasticsearch et Kibana, alors suivez ces instructions.

Cette vidéo suppose que vous utilisez Certificats signés publiquement. Si vous utilisez Certificats auto-signés, va ici À déterminer.

Exigences

- Une instance en cours d'exécution d'Elasticsearch et de Kibana.

- Une instance d’un autre serveur Ubuntu 20.04 exécutant n’importe quel type de service.

Processus

Installer Logstash [09:20]

Ouvrez votre terminal. Accédez à ceci.Dépôt GitHub, et clonez le dépôt avec les commandes suivantes :

git init

git remote add origin https://github.com/evermight/elasticsearch-ingest.git

git pull origin master

cd part-3

Installez Logstash avec ces commandes :

wget -qO - https://artifacts.elastic.co/GPG-KEY-elasticsearch | sudo gpg --dearmor -o /usr/share/keyrings/elasticsearch-keyring.gpg

sudo apt-get install -y apt-transport-https

echo 'deb [signed-by=/usr/share/keyrings/elasticsearch-keyring.gpg] https://artifacts.elastic.co/packages/8.x/apt stable main' | sudo tee /etc/apt/sources.list.d/elastic-8.x.list

sudo apt-get update && sudo apt-get install -y logstash

configurez les variables d'environnement avec ces commandes :

cp env.sample.env .env

vi.env

Apportez maintenant les modifications en conséquence

PROJECTPATH="/absolute/path/to/current/directory"

ELASTICHOST="your.domain.or.ip:9200"

ELASTICSSL="use only the string true or the string false"

ELASTICUSER="elastic"

ELASTICPASS="<Your Elastic Password>"

Ingérer zipgeo.csv (géotype de champ de points) [11:45]

Dans le même terminal, exécutez maintenant la commande ci-dessous :

./01-zip_geo.sh

et après un certain temps, il chargera le zip_geo.csv fichier et créez également un index enrichi pour celui-ci.

Il utilisera les éléments suivants :

- contenu du logstash situé à

logstash/zip_geo.confdéposer. - cartographie du contenu situé dans le

mapping/zip_geo.jsondéposer. - contenu de la politique situé dans le

policy/zip_geo.jsondéposer.

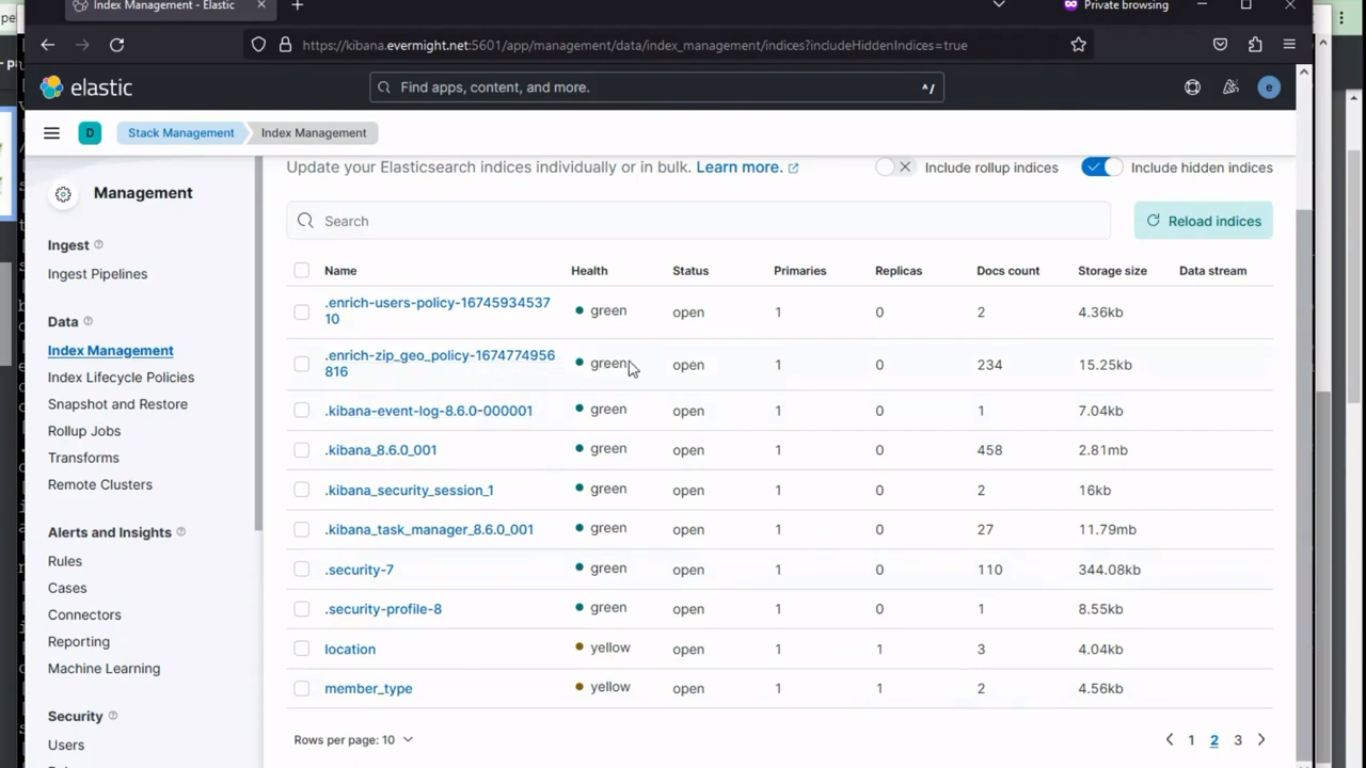

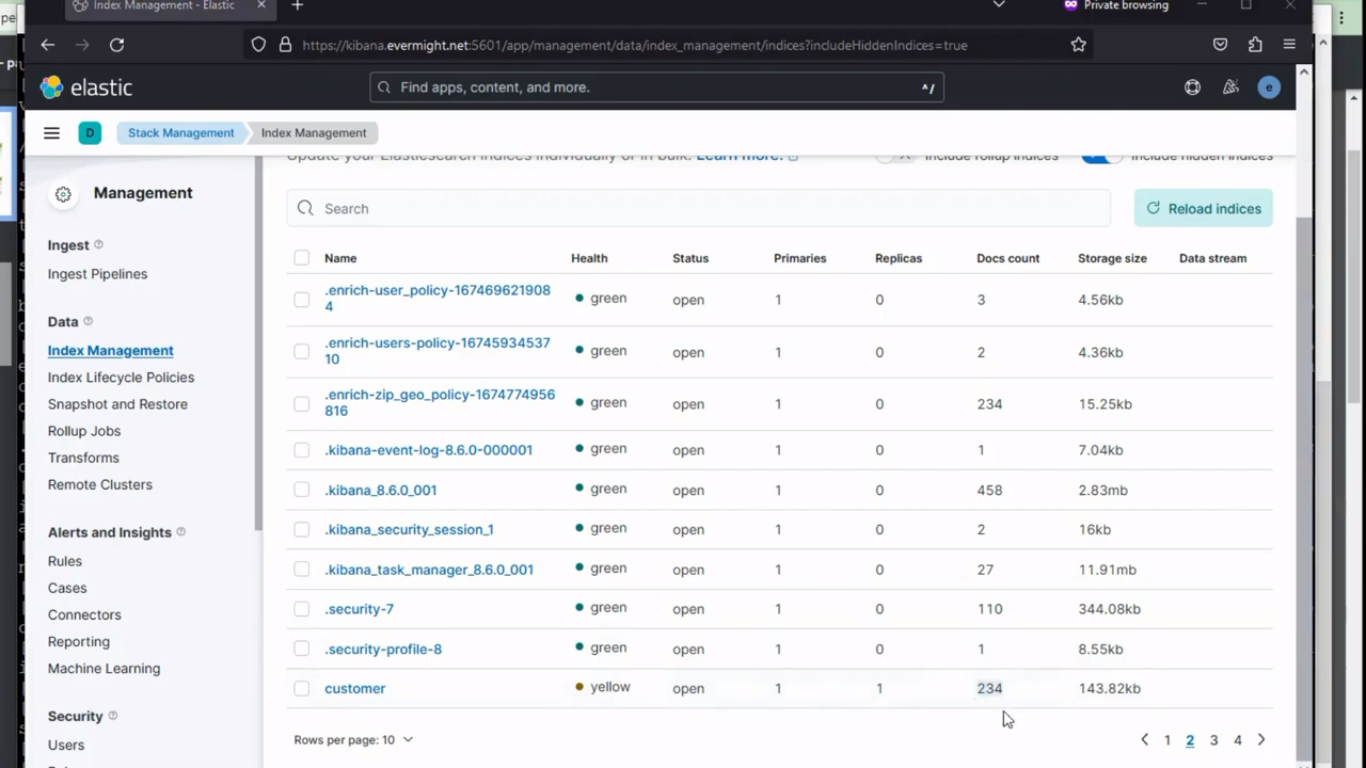

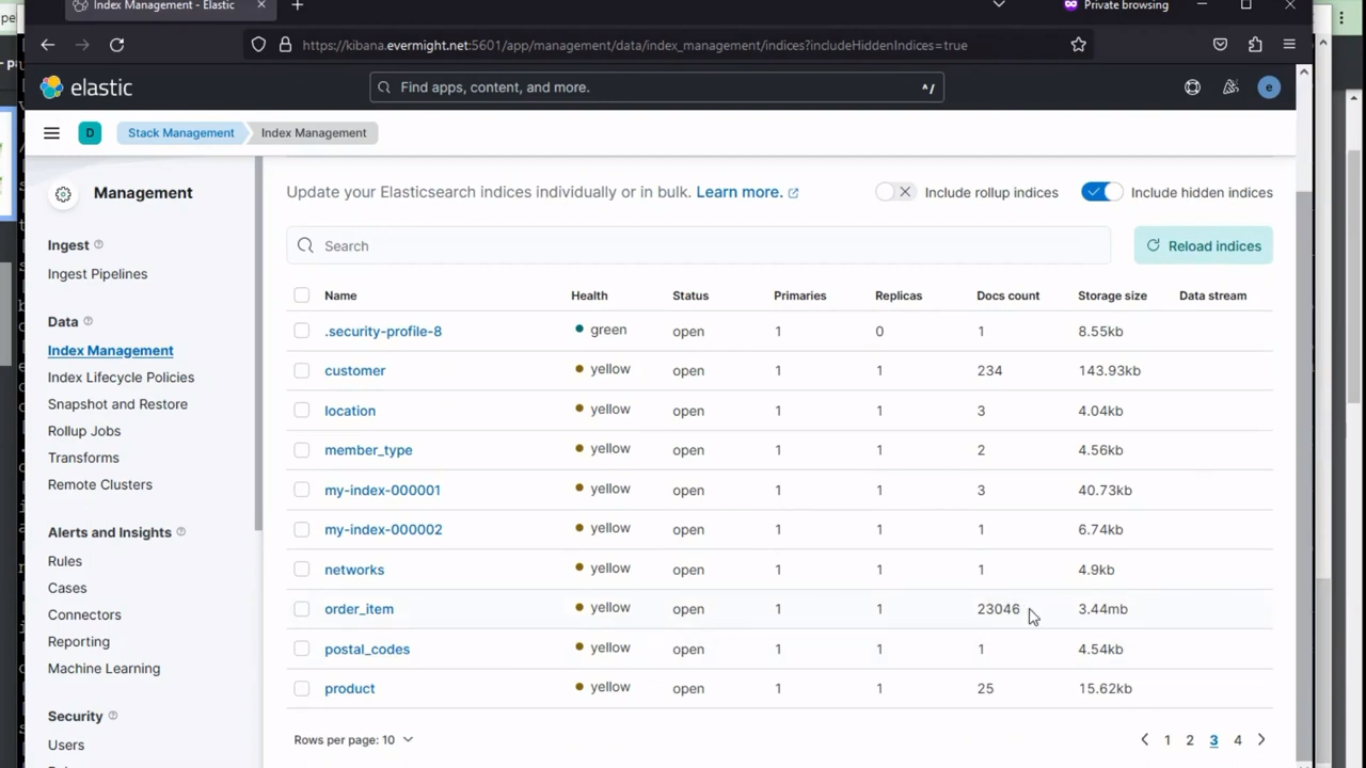

Pour confirmer que l'index a été créé, accédez à Gestion de la pile > Gestion des index. Et vous devriez voir un résultat similaire à l'image ci-dessous :

Politique relative au code postal géographique

Politique relative au code postal géographique

Index pour zip geo

Index pour zip geo

Ingérer customer.csv [19:55]

Exécutez maintenant la commande ci-dessous pour customer.csv déposer:

./02-customer.sh

And after some time, it will load the customer.csv fichier et créez également un index enrichi pour celui-ci.

Il utilisera les éléments suivants :

- contenu du logstash situé à

logstash/customer.confdéposer. - cartographie du contenu situé dans le

mapping/customer.jsondéposer. - contenu de la politique situé dans le

policy/customer.jsondéposer. - contenu du pipeline situé à

pipeline/customer.jsondéposer.

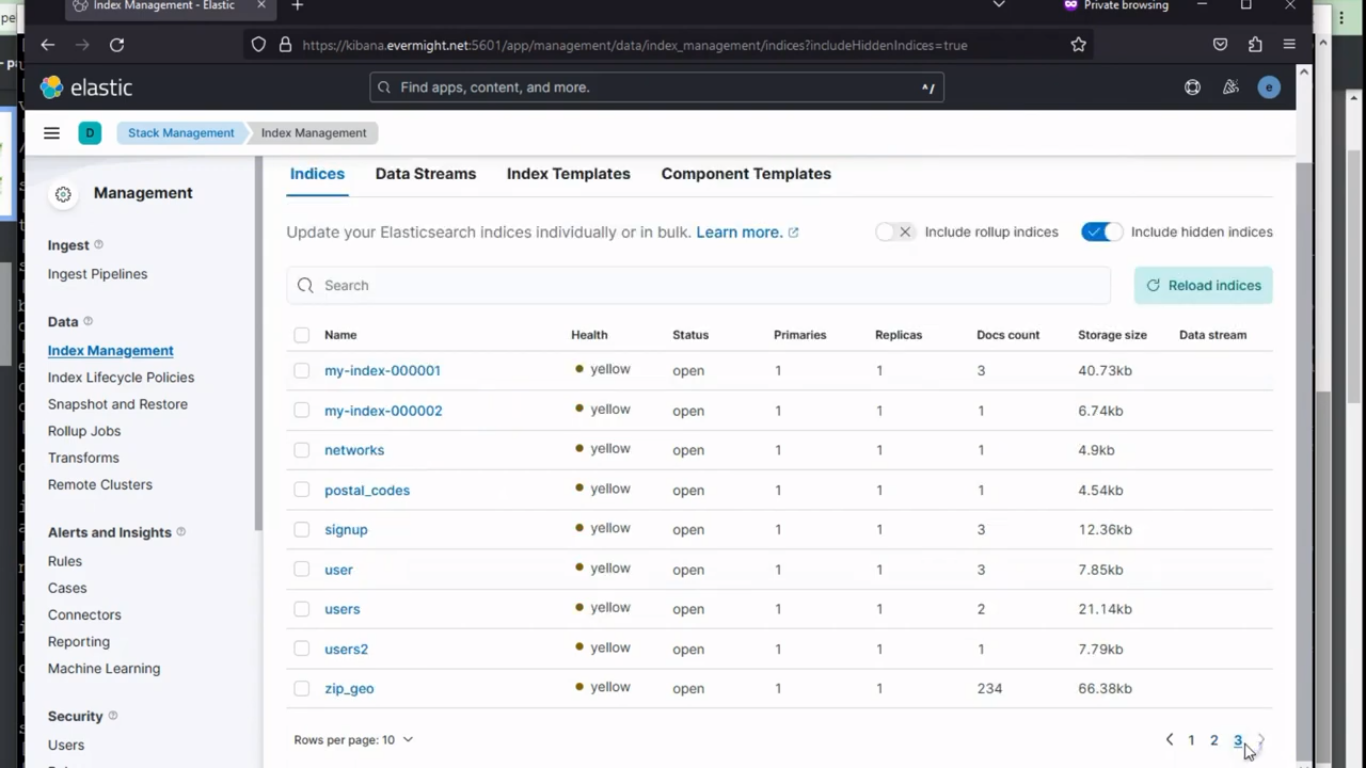

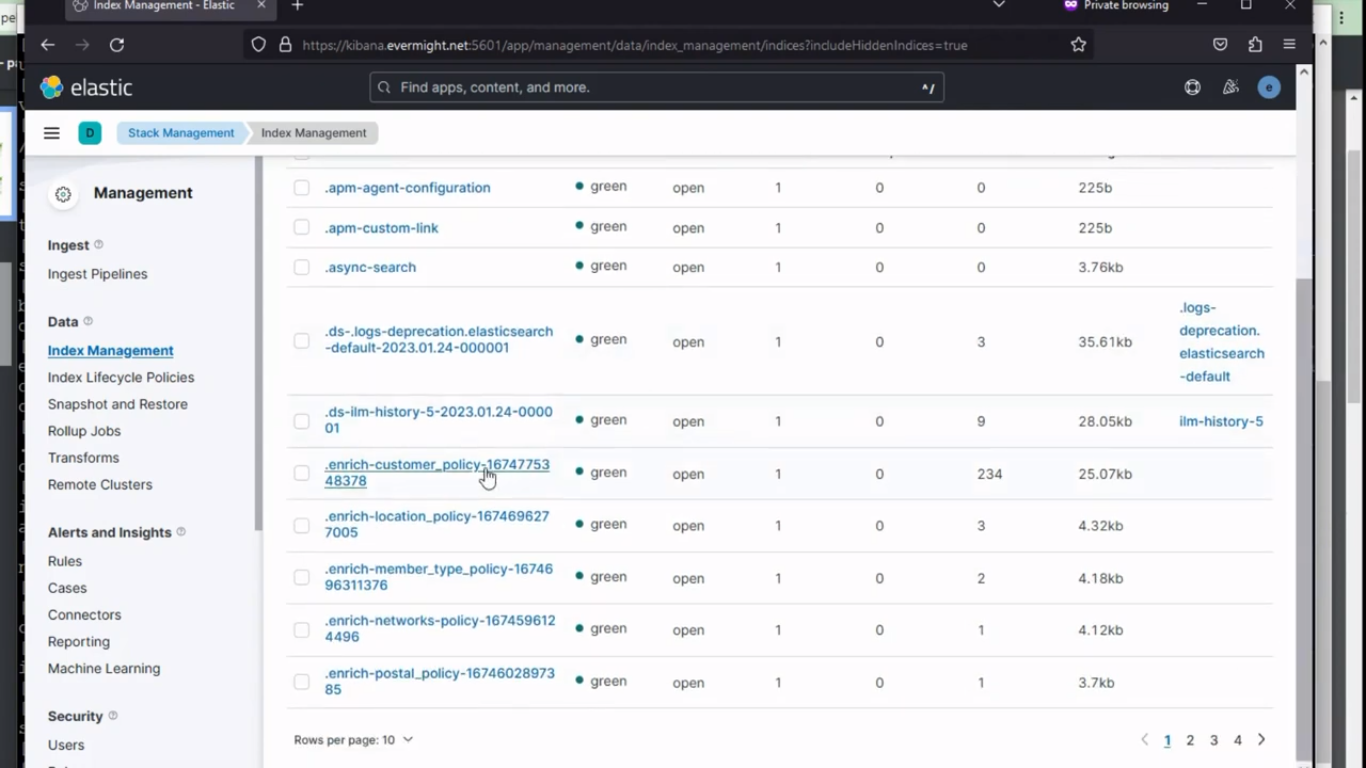

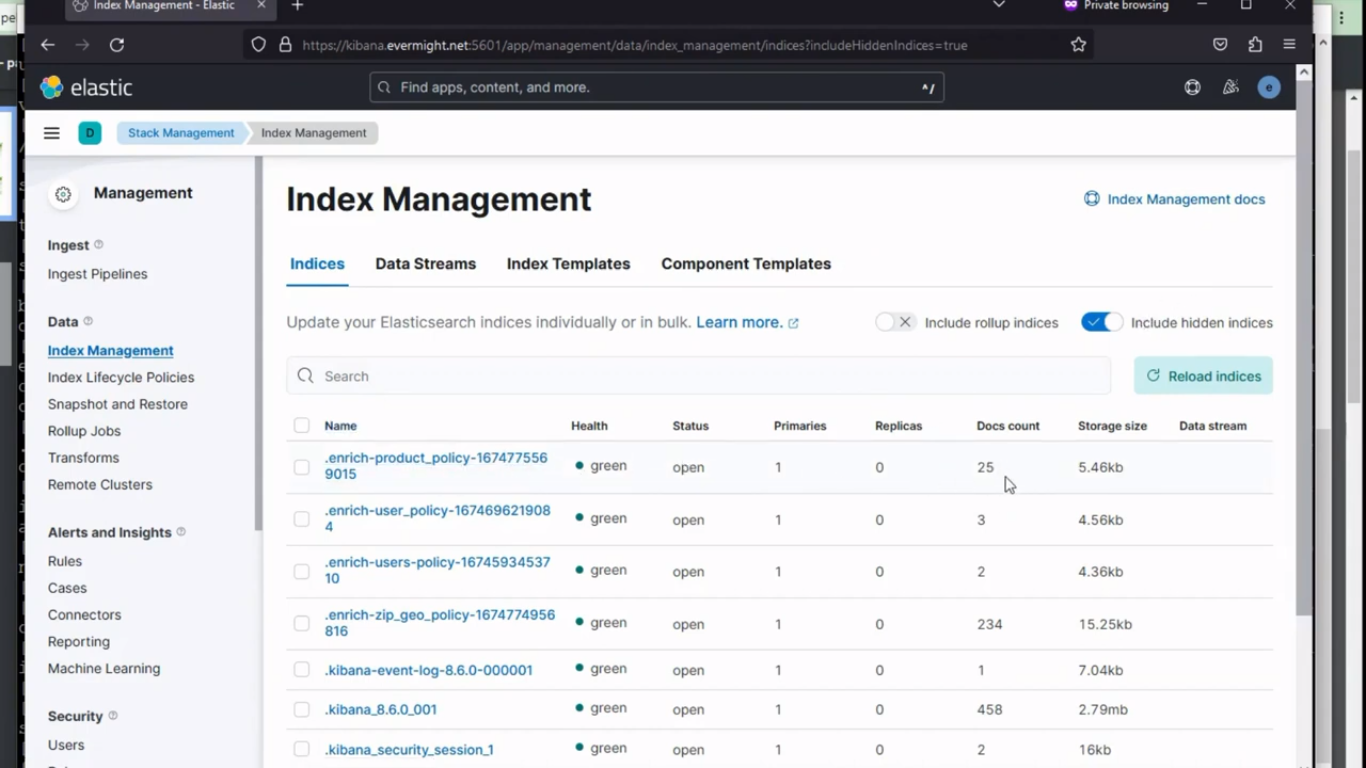

Pour confirmer que l'index a été créé, accédez à Gestion de la pile > Gestion des index. Et vous devriez voir un résultat similaire à l'image ci-dessous :

Politique pour le client

Politique pour le client

Index pour le client

Index pour le client

Ingérer le produit.csv [23:57]

Exécutez maintenant la commande ci-dessous pour product.csv déposer:

./03-product.sh

And after some time, it will load the product.csv fichier et créez également un index enrichi pour celui-ci.

Il utilisera les éléments suivants :

- contenu du logstash situé à

logstash/product.confdéposer. - contenu de la politique situé dans le

policy/product.jsondéposer.

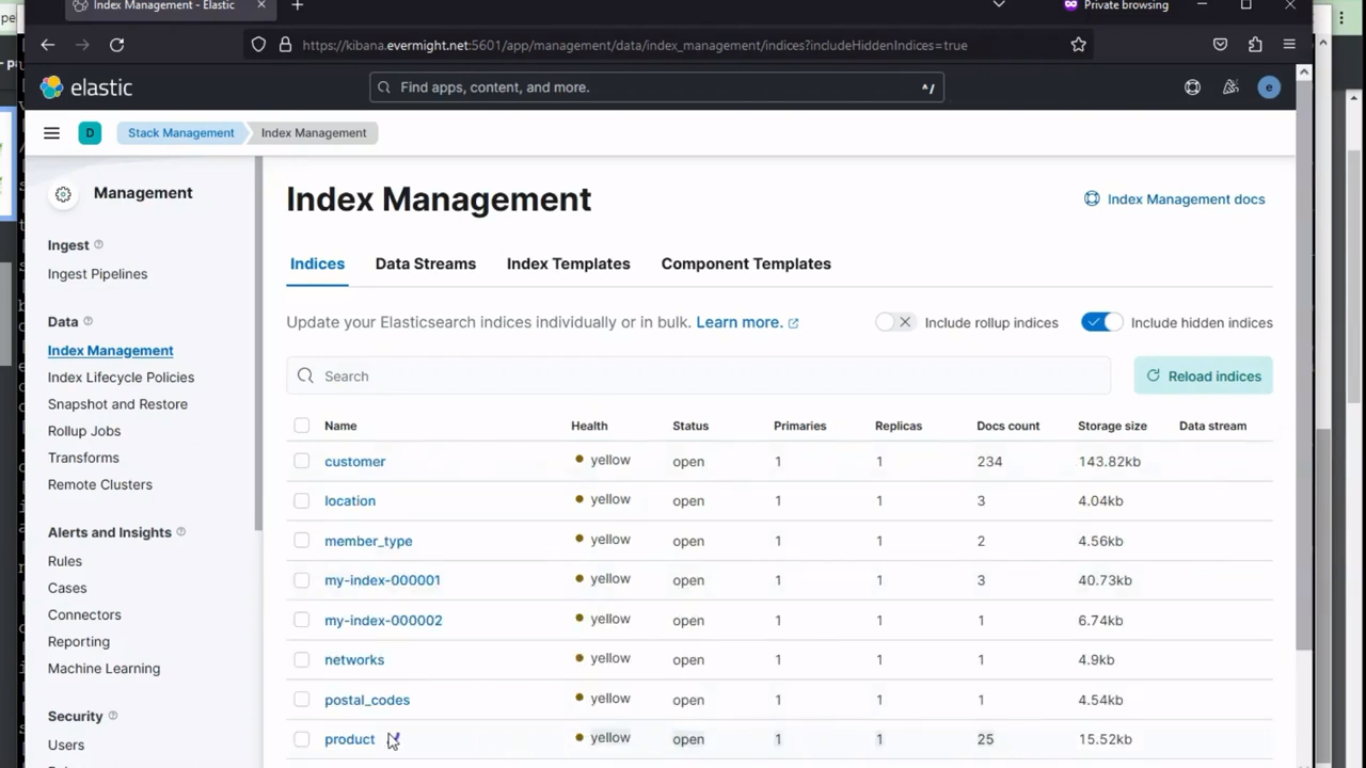

Pour confirmer que l'index a été créé, accédez à Gestion de la pile > Gestion des index. Et vous devriez voir un résultat similaire à l'image ci-dessous :

Politique relative aux produits

Politique relative aux produits

Index du produit

Index du produit

Ingérer order_item.csv [26:00]

Exécutez maintenant la commande ci-dessous pour order_item.csv déposer:

./04-order_item.sh

And after some time, it will load the order_item.csv fichier et créez également un index enrichi pour celui-ci.

Il utilisera les éléments suivants :

- contenu du logstash situé à

logstash/order_item.confdéposer. - contenu de la politique situé dans le

policy/order_item.jsondéposer. - contenu du pipeline situé à

pipeline/order_item.jsondéposer.

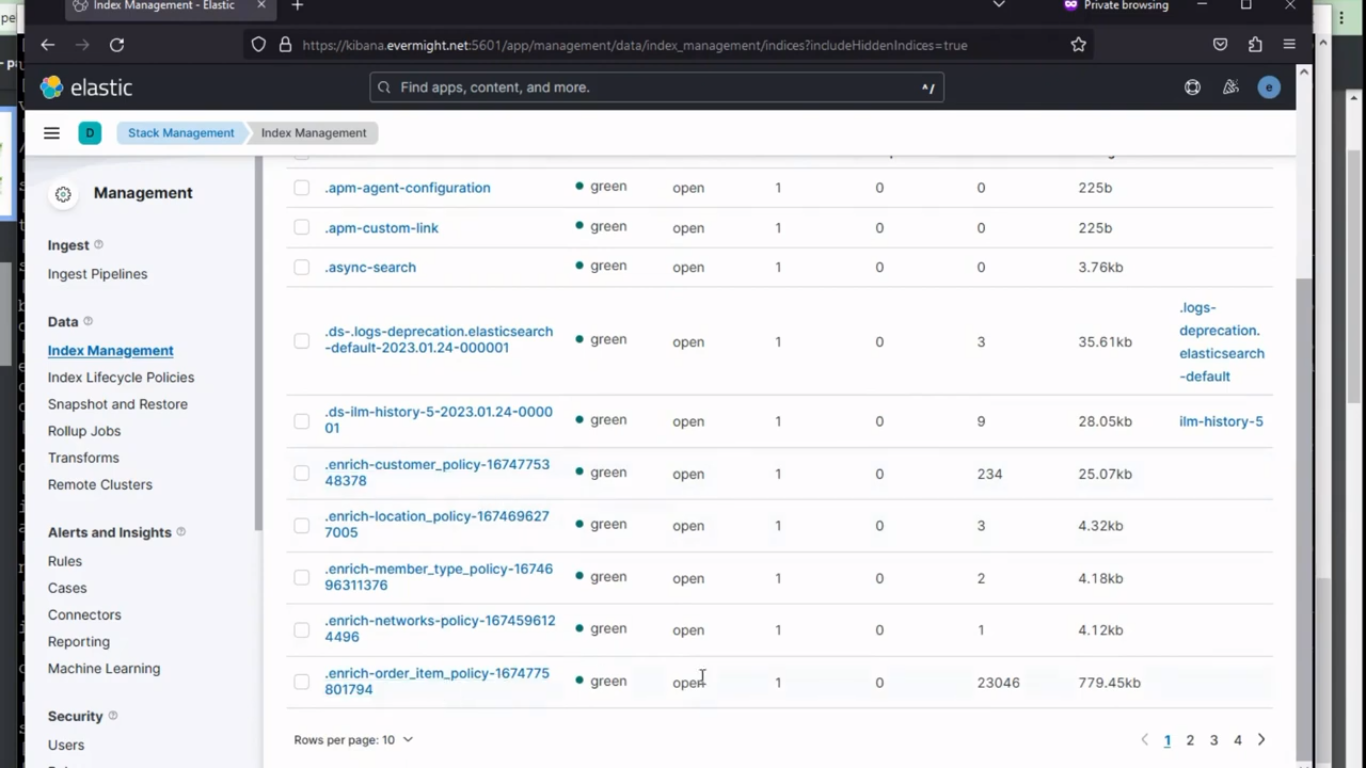

Pour confirmer que l'index a été créé, accédez à Gestion de la pile > Gestion des index. Et vous devriez voir un résultat similaire à l'image ci-dessous :

Politique relative aux articles commandés

Politique relative aux articles commandés

Index pour l'article de commande

Index pour l'article de commande

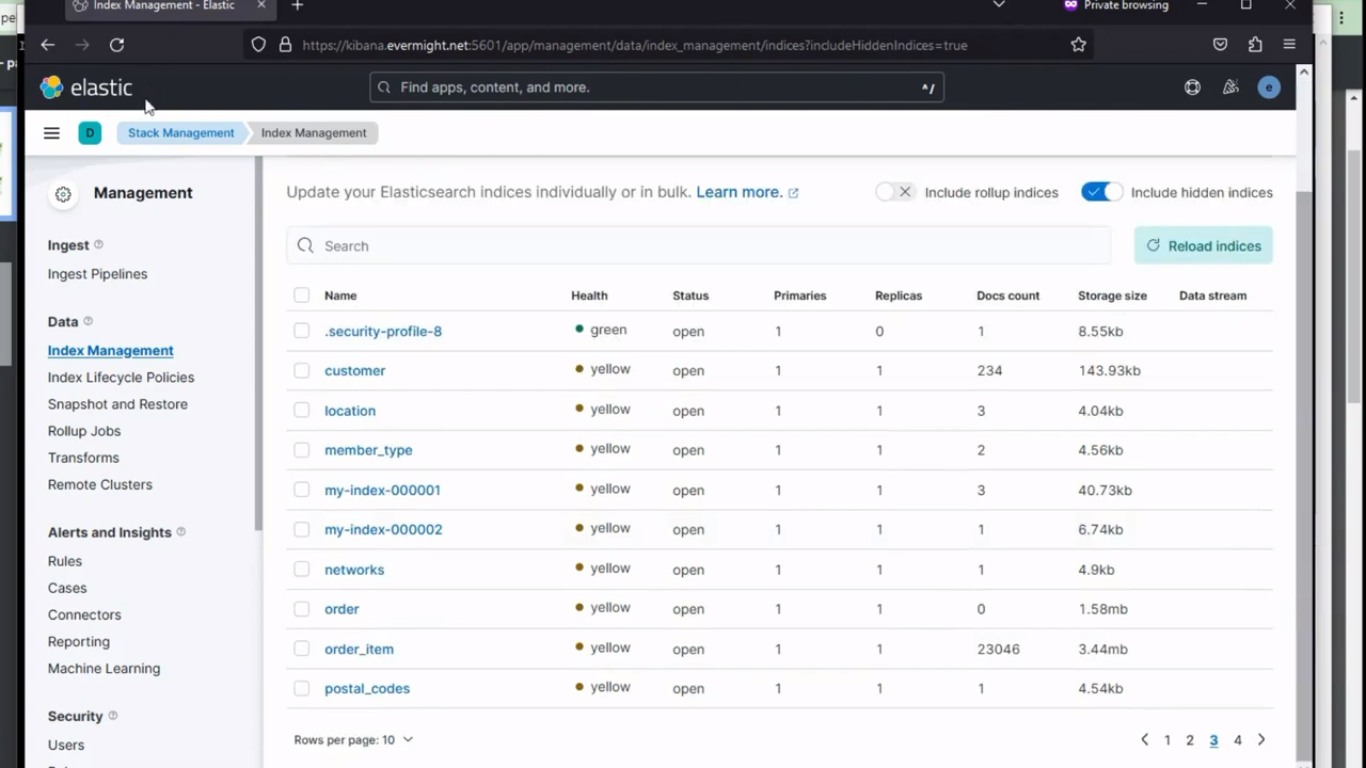

Ordre d'ingestion.csv [27:44]

Exécutez maintenant la commande ci-dessous pour order.csv déposer:

./05-order.sh

And after some time, it will load the order.csv fichier et créez également un index enrichi pour celui-ci.

Il utilisera les éléments suivants :

- contenu du logstash situé à

logstash/order.confdéposer. - cartographie du contenu situé dans le

mapping/order.jsondéposer. - contenu du pipeline situé à

pipeline/order.jsondéposer.

Pour confirmer que l'index a été créé, accédez à Gestion de la pile > Gestion des index. Et vous devriez voir un résultat similaire à l'image ci-dessous :

Index pour la commande

Index pour la commande

Facilité de course

Exécutez la commande ci-dessous pour détruire toutes les ressources précédemment créées

./teardown.sh

Et si vous souhaitez exécuter tous les scripts .sh en même temps, vous pouvez utiliser la commande ci-dessous à la place, et elle exécutera tous les scripts dans l'ordre correct dans lequel ils sont censés être exécutés ;

./run.sh

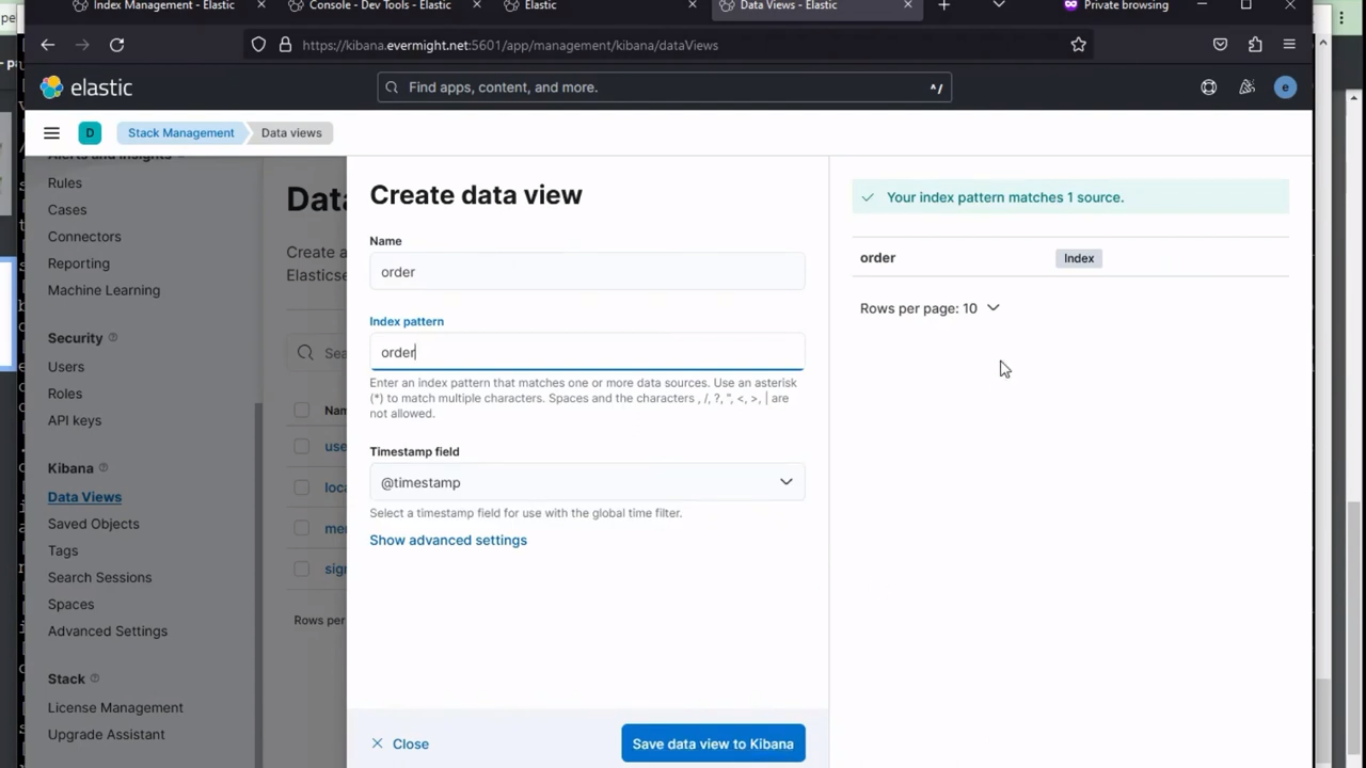

Données de test avec visualisation [33:05]

Aller à Gestion de la pile > Vues de données, et créez une nouvelle vue de données Kibana comme indiqué dans l'image ci-dessous :

Création de vues de données

Création de vues de données

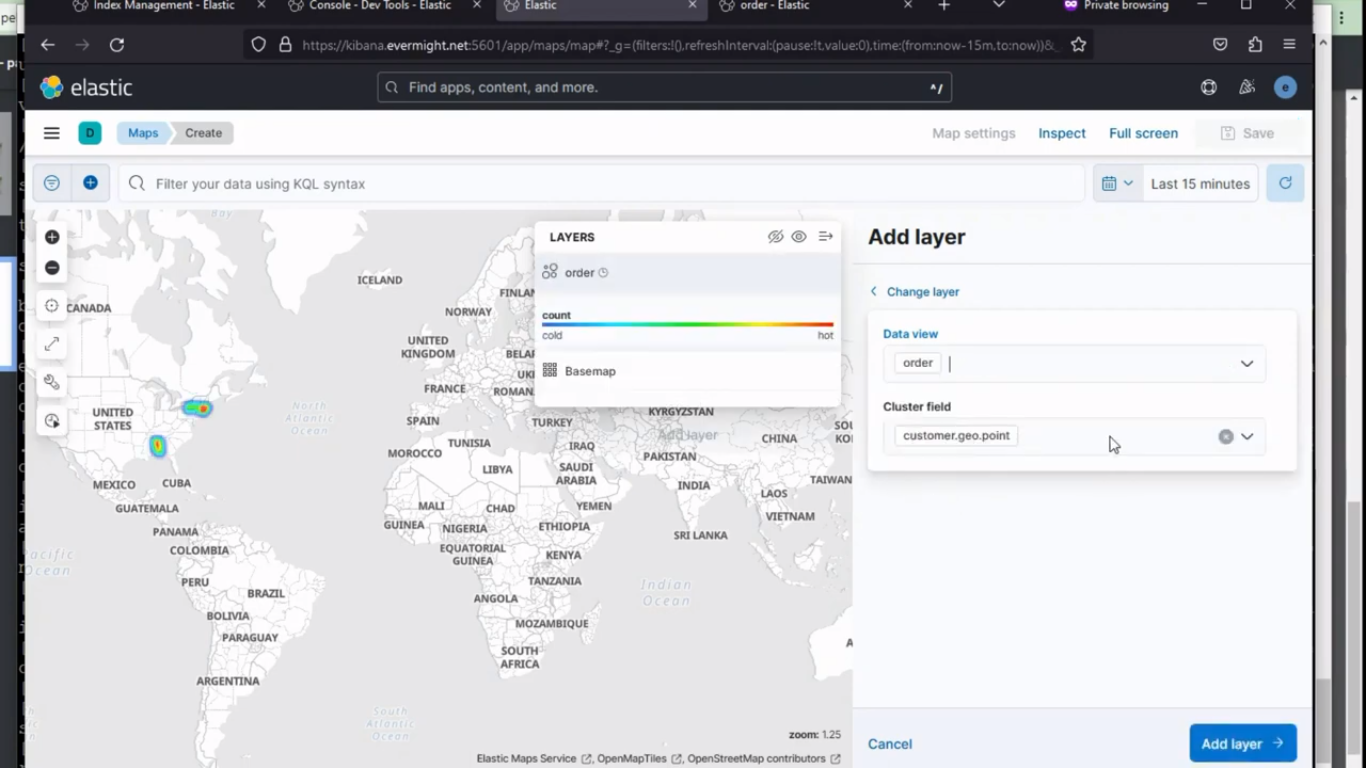

À Kibana, sous Analytique go to Visualiser la bibliothèque et cliquez sur Créer une nouvelle visualisation, puis choisissez Cartes parmi les options, puis cliquez sur Ajouter un calque, et choisissez un Carte thermique, cliquez sur la vue des données et choisissez commande.

vous devriez voir un résultat similaire à celui-ci :

Sélection de carte thermique

Sélection de carte thermique

puis cliquez sur Add layer.

Maintenant dans le métrique champ, sélectionnez les éléments suivants :

Aggregation: Sum

Field: order_items.product.price

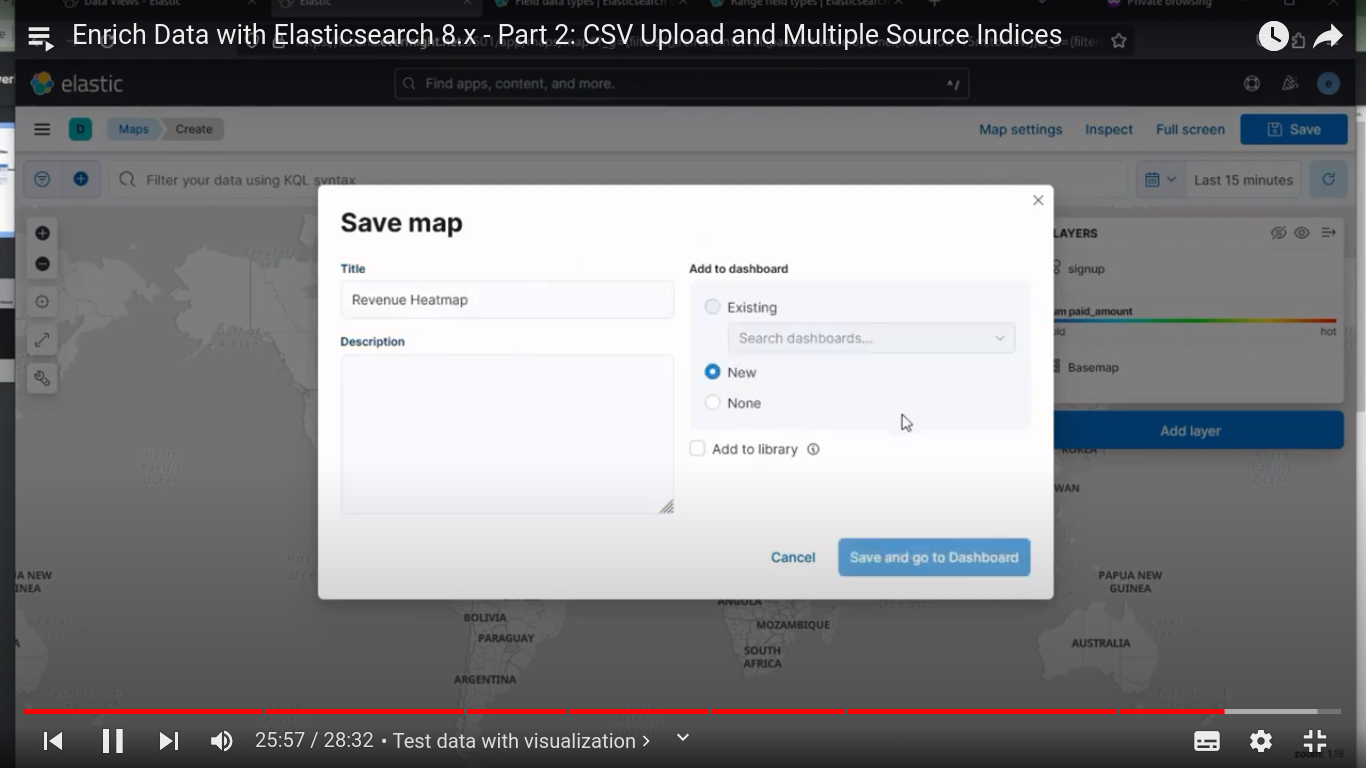

Enregistrez maintenant la carte en cliquant sur Enregistrer et accéder au tableau de bord

Enregistrer la carte thermique

Enregistrer la carte thermique

Enregistrer le tableau de bord sous Revenus par région Partie 3, tableau de bord existant Tableau de bord de démonstration.

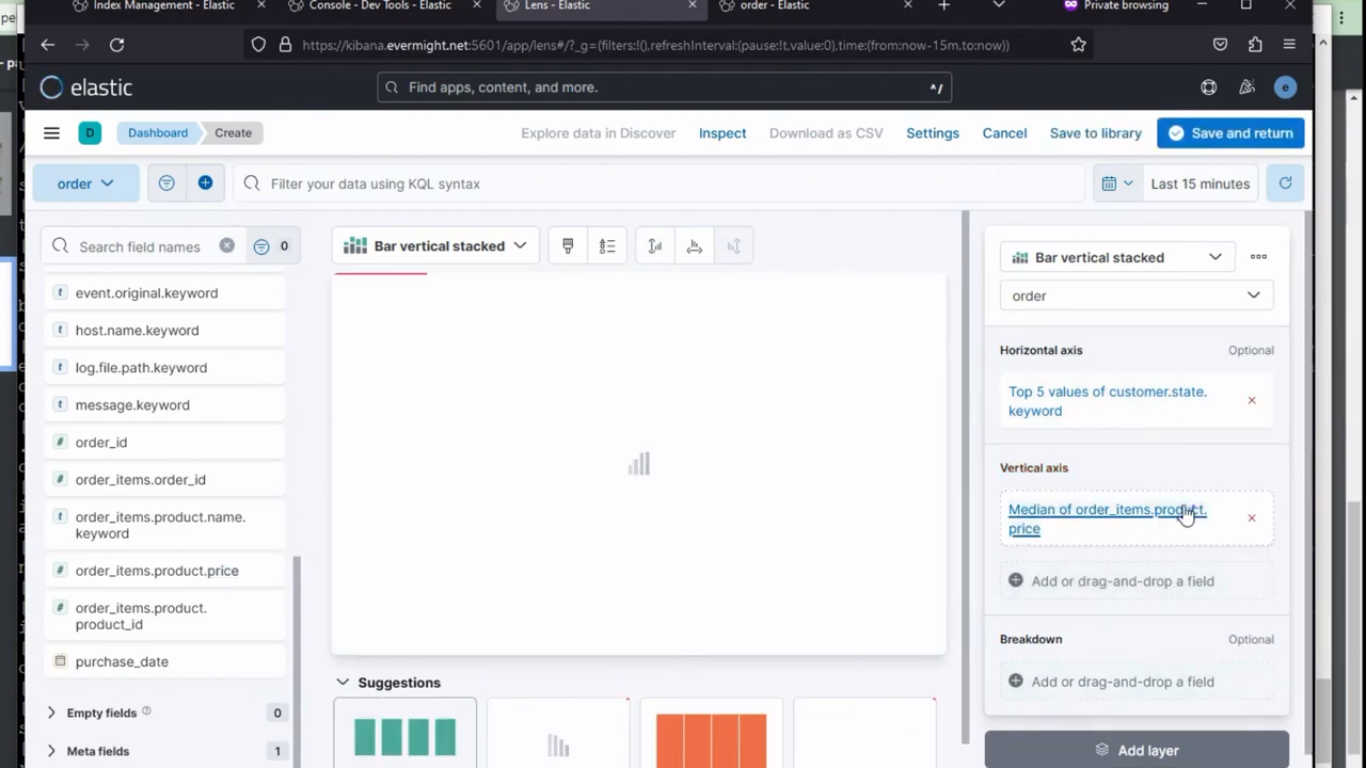

Créez une deuxième visualisation sur les données de commande en faisant glisser et en déposant les métriques requises de l'axe horizontal de gauche à droite, puis choisissez sum sur l'axe vertical comme indiqué dans l'image ci-dessous :

2ème visualisation

2ème visualisation

Then click on Enregistrer et revenir.

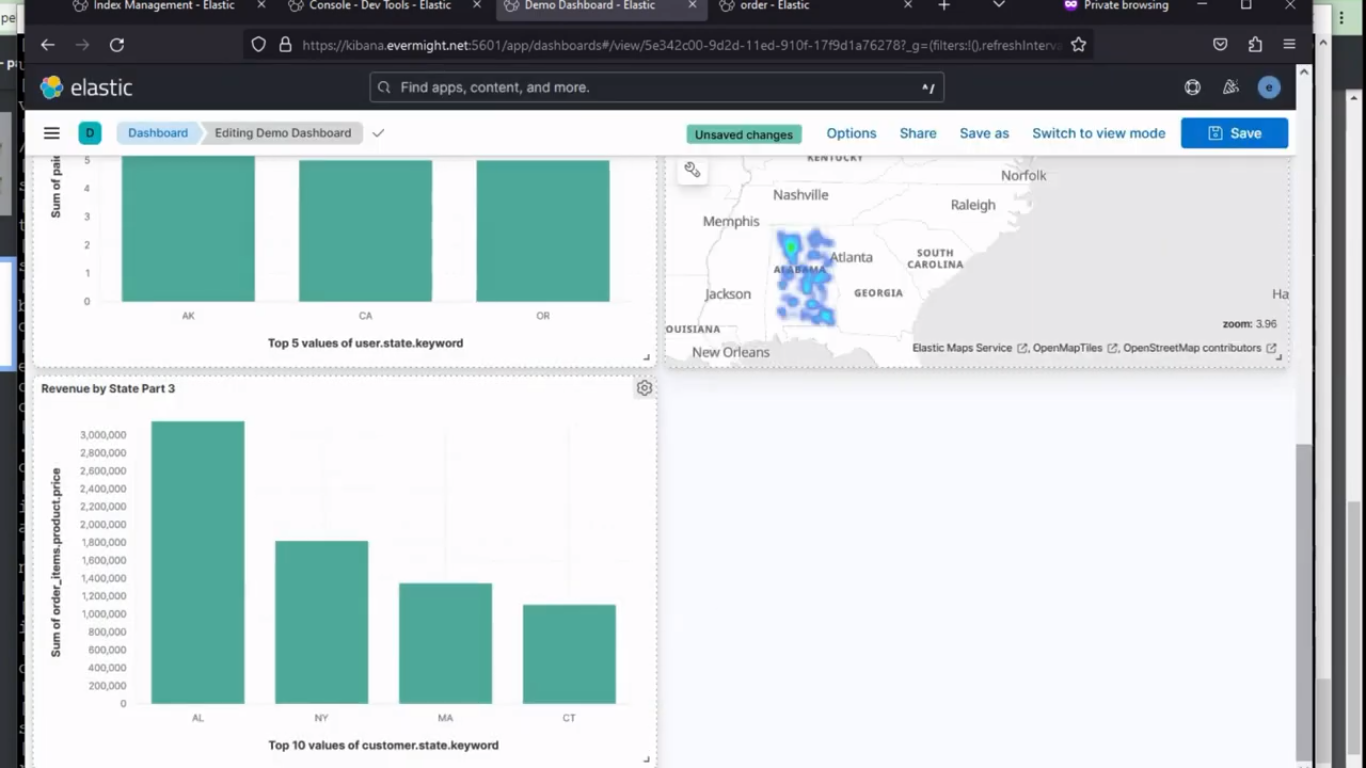

Les deux visualisations

Les deux visualisations